現在、私は Google Cloud の「Professional Cloud Data Engineer」認定資格の取得に向けて勉強しています。

この資格を目指す理由は、将来的にセキュリティに特化したエンジニアを目指すにあたり、インフラ領域だけでなく、その他の分野についても知識を深める必要があると考えたからです。

Google Cloud は、生成 AI が登場する以前から、BigQuery をはじめとするデータ関連サービスに注力してきました。今後、Google Cloud のエンジニアとしてキャリアを築いていく中で、データ領域の知識は不可欠であると感じています。

以上の理由から、「Professional Cloud Data Engineer」認定資格の取得を目指すことに決めました。

今回は、オライリー・ジャパンの『データエンジニアリングの基礎』という書籍を読み、Google Cloud のデータ系サービスと関連づけながら、「データエンジニアリングとは何か」について整理しました。

ぜひ、最後までご覧いただけると嬉しいです!

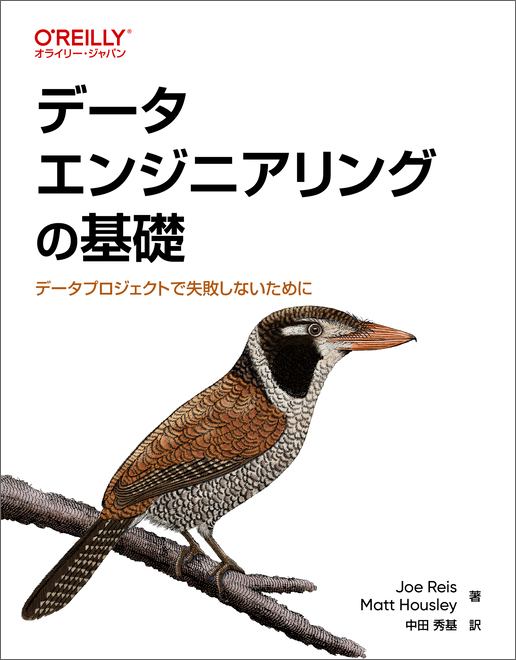

データエンジニアリングライフサイクル

データエンジニアリングライフサイクルとは、データが生まれてから、ビジネス上の価値ある洞察やアクションにつながるまでのプロセス全体を指します。このライフサイクルは、大きく以下の5つの段階で構成されます。

1. 生成 (Generate)

すべてのデータは、まずどこかで「生成」されます。これは、アプリケーションのトランザクションログ、ウェブサイトのクリックストリーム、IoTデバイスからのセンサーデータ、ソーシャルメディアの投稿など、多種多様なソースから発生します。この段階では、どのようなデータが、どのような形式で、どのくらいの頻度で生成されるかを把握することが重要です。

2. 保存 (Store)

生成された生データや処理途中のデータは、後続の処理や分析のために「保存」されます。データの種類(構造化、半構造化、非構造化)、量、アクセス頻度、耐久性の要件などに応じて、最適なストレージソリューションを選択します。Google Cloudでは、オブジェクトストレージのCloud Storage、リレーショナルデータベースのCloud SQLやSpanner、NoSQLデータベースのBigtableやFirestoreなどが利用されます。

3. 取り込み (Ingest)

保存されたデータを、分析や処理を行うシステムへ移動させるのが「取り込み」の段階です。データソースや要件に応じて、バッチ処理またはストリーミング処理が用いられます。例えば、定期的に大量データを処理する場合はDataflowやDataprocを用いたバッチ処理、リアルタイムで発生するデータを取り込む場合はPub/SubとDataflowを組み合わせたストリーミング処理などが考えられます。データをデータウェアハウスであるBigQueryにロードすることもこの段階に含まれます。

4. 変換 (Transform)

取り込まれたデータは、多くの場合、そのままでは分析に適していません。そのため、「変換」処理を行い、データをクレンジング(欠損値処理、異常値除去)、フォーマット統一、他のデータソースとの結合、集計などを行います。これにより、データは分析や機械学習モデルのトレーニングに利用しやすい、一貫性のある信頼性の高い形式になります。Google Cloudでは、Dataflow, Dataprep by Trifacta, BigQuery (SQLを用いたELT) などがこの処理に用いられます。

5. 提供 (Serve / Analyze / Visualize)

最終段階として、変換され価値ある情報となったデータは、ビジネスユーザー、データサイエンティスト、あるいは他のアプリケーションが利用できるように「提供」されます。BigQueryを用いた高度な分析、Looker StudioやLookerを用いたデータの可視化とダッシュボード作成、Vertex AIを用いた機械学習モデルの予測サービス提供などがこの段階にあたります。分析結果や洞察を、意思決定者や関係者が理解しやすい形で届けることが重要です。

データエンジニアリングライフサイクルのまとめ

データエンジニアリングは、データが生成されてから最終的に活用されるまでの一連のプロセスを体系的に扱う領域です。まず、アプリケーションのログやIoTデバイスなどからデータが「生成」され、それが適切なストレージに「保存」されます。続いて、分析や処理のために「取り込み」が行われ、使いやすい形式に「変換」されます。最後に、変換されたデータは、可視化や分析、機械学習などの形で「提供」され、ビジネス上の意思決定やサービスの改善に役立てられます。これら一連の流れを理解し適切に設計することが、データ活用の基盤となります。

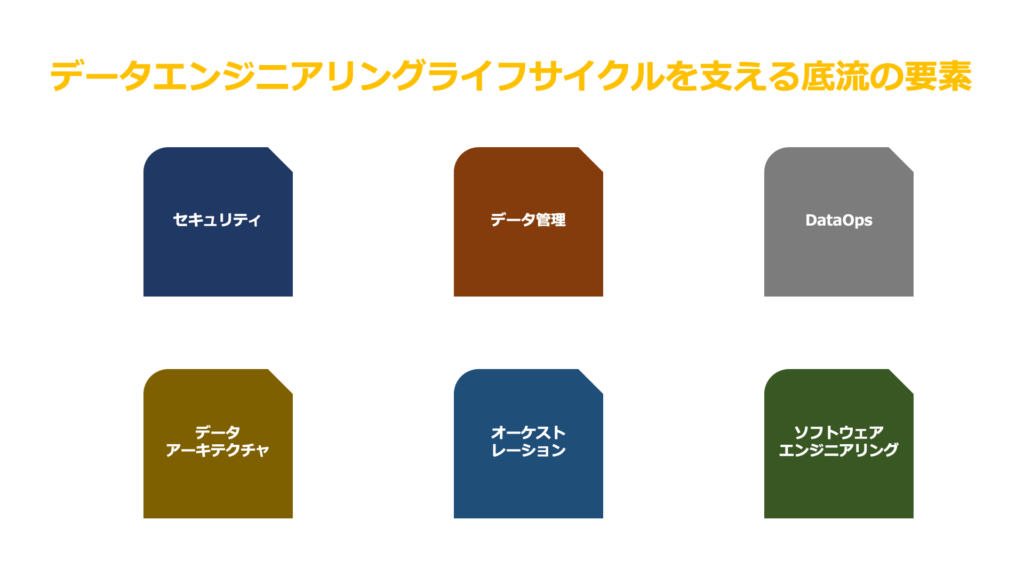

データエンジニアリングライフサイクルを支える底流の要素

データエンジニアリングライフサイクル(生成、保存、取り込み、変換、提供)を円滑かつ効果的に機能させるためには、個々の段階を最適化するだけでなく、ライフサイクル全体を横断的に支える、いわば「底流」となる要素が極めて重要です。底流とは、表面には現れにくいが、物事の背景や根底に継続的に存在し、全体の動向や方向性に影響を与える流れのことです。

これらは、堅牢で信頼性が高く、価値を生み出すデータソリューションを構築するための基盤となります。

1. セキュリティ (Security)

データライフサイクルのあらゆる段階において、データの保護は最優先事項です。これには、不正アクセスを防ぐための適切な認証・認可(Google Cloud IAM)、保存データと転送中データの暗号化(Cloud Storageのデフォルト暗号化、Cloud KMSによる鍵管理)、ネットワーク境界の保護(VPC Service Controls)、操作ログの監視と監査(Cloud Audit Logs, Security Command Center)などが含まれます。セキュリティは設計段階から組み込まれるべき要素です。

2. データ管理 (Data Governance / Management)

データの品質、可用性、利用規約、コンプライアンスを維持・向上させるための組織的な取り組みです。データの意味を定義・共有するデータカタログ(Data Catalog)、データの来歴を追跡するデータリネージ、データ品質の監視と改善、機密データのマスキングや匿名化、そしてGDPRなどの規制遵守が含まれます。Dataplex はこれらのデータ管理タスクを一元的に行うのに役立ちます。適切なデータ管理により、データの信頼性が担保され、データ活用が促進されます。

3. DataOps

DevOpsの原則とプラクティスをデータ分析のワークフローに適用するアプローチです。アジャイルな開発手法、パイプラインの自動テスト、継続的インテグレーション/継続的デリバリー(CI/CD)、インフラストラクチャのコード化(IaC)、バージョン管理、そしてパイプラインのパフォーマンスと健全性のモニタリング(Cloud Monitoring, Cloud Logging)などが含まれます。DataOpsは、データチームのコラボレーションを促進し、開発サイクルの短縮、品質向上、信頼性の高い運用を実現します。

4. データアーキテクチャ (Data Architecture)

ビジネス要件を満たすために、データがどのように収集、保存、処理、統合、利用されるかの青写真(設計図)です。スケーラビリティ、パフォーマンス、可用性、コスト効率、将来の拡張性などを考慮し、適切なGoogle Cloudサービス(BigQuery, Cloud Storage, Dataflow, Pub/Sub, Cloud Composer など)や技術、データモデリング手法を選択し、システム全体の構造を定義します。優れたアーキテクチャは、ライフサイクル全体の効率性と持続可能性の鍵となります。

5. オーケストレーション (Orchestration)

データパイプラインは多くの場合、複数の独立したタスクやジョブ(例:データの取り込み、変換処理、モデルのトレーニング、結果の出力)で構成されます。オーケストレーションは、これらのタスク間の依存関係を定義し、実行順序、スケジュール、エラーハンドリング、再試行などを管理・自動化する仕組みです。Google Cloudでは、Cloud Composer(マネージドApache Airflow)や Workflows が、複雑なデータパイプラインの実行を効率的かつ確実に管理するために利用されます。

6. ソフトウェアエンジニアリング (Software Engineering)

データパイプラインを構築するコード(Python, SQL, Javaなど)もソフトウェアです。そのため、コードの品質、再利用性、テスト容易性、保守性を高めるためのソフトウェアエンジニアリングのベストプラクティスを適用することが不可欠です。具体的には、バージョン管理(Git)、単体テスト・統合テストの作成、コードレビューの実施、モジュール化による再利用性の向上、適切なドキュメンテーションなどが挙げられます。これにより、パイプラインの信頼性と開発効率が向上します。

データエンジニアリングライフサイクルを支える底流の要素のまとめ

データエンジニアリングにおいては、単にデータを処理するだけでなく、データ基盤や運用体制を整備することが極めて重要です。

セキュリティ対策やガバナンスを徹底することで、データの信頼性と品質を確保し、安心して活用できる環境を築きます。また、DataOpsを導入して開発と運用の連携を強化し、適切なアーキテクチャ設計によって将来的な拡張性も担保します。さらに、オーケストレーションによる処理の自動化や、ソフトウェア工学の知見を取り入れた基盤構築により、信頼性を高めることも欠かせません。

これら全ての要素を統合的に推進することで、持続可能で効果的なデータ活用環境が実現されるのです。

適切なデータアーキテクチャ設計の底流にある原則

Google Cloud上で効果的かつ持続可能なデータソリューションを構築するためには、具体的な技術要素の選定だけでなく、その設計思想の根底にある原則、すなわち「底流」を理解し実践することが不可欠です。これらは、変化に強く、信頼性が高く、効率的なデータアーキテクチャを導くための指針となります。Professional Cloud Data Engineerとして、以下の原則を常に念頭に置くことが重要です。

1. セキュリティを優先する

セキュリティは、アーキテクチャ設計の初期段階から不可欠な要素として組み込まれるべきです。後付けではなく、設計のあらゆる側面(データ、インフラ、アクセス、ネットワーク)でセキュリティ要件を考慮します。Google CloudのIAMによる最小権限の原則、VPC Service Controlsによる境界防御、保存時・転送時のデータ暗号化(Cloud KMS活用含む)、Cloud Audit Logsによる監査証跡の確保などを、アーキテクチャの基本構造として設計します。

2. 障害に備える

クラウド環境では、個々のコンポーネントの障害は起こり得るものと想定すべきです。単一障害点を排除し、冗長構成(例: リージョン間のCloud Storageバケットレプリケーション、Compute Engineマネージドインスタンスグループ)、自動フェイルオーバー、リトライメカニズム、冪等性のある処理などを設計に盛り込み、システム全体の回復力(レジリエンス)を高めます。Cloud MonitoringとCloud Loggingによる監視とアラートも不可欠です。

3. スケーラビリティ設計

データ量、ユーザー数、処理負荷の増減に柔軟に対応できる設計を目指します。Google Cloudのマネージドサービス(BigQuery, Dataflow, Pub/Sub, Cloud Spannerなど)が持つ自動スケーリング機能や水平スケーリング能力を最大限に活用できるアーキテクチャを選択します。負荷に応じて自動的にリソースが調整されることで、パフォーマンスとコスト効率のバランスを取ります。

4. 疎結合システムを構築する

システム内のコンポーネント間の依存関係を最小限に抑えることで、変更容易性と独立性を高めます。各コンポーネントが独立して開発、デプロイ、スケール、障害対応できるよう、Pub/Subのような非同期メッセージングや、Cloud Functions, Cloud Run上のマイクロサービス、明確に定義されたAPI(API Gateway, Apigee)などを介して連携させます。これにより、システム全体としての柔軟性と堅牢性が向上します。

5. 共通コンポーネントを賢く選択する

車輪の再発明を避け、実績のある共通パターン、ライブラリ、そして特にGoogle Cloudが提供する高機能なマネージドサービスを積極的に活用します。これにより、開発速度の向上、運用負荷の軽減、ベストプラクティスの適用が期待できます。ただし、あらゆるケースで共通化が最適とは限らないため、コンテキストを理解し、トレードオフを考慮して「賢く」選択することが重要です。

6. 可逆な決定をする

将来の技術進化やビジネス要件の変化に備え、可能な限り変更や置き換えが容易な設計判断を行います。特に、データベース選択やコアなフレームワークなど、後から変更することが困難でコストもかかる「one-way door」な決定は慎重に行い、インターフェースによる抽象化や標準技術の採用などで「two-way door」にする努力をします。技術的ロックインを意識的に避けることも含まれます。

7. FinOpsを活用する

クラウド利用における財務的なアカウンタビリティとコスト最適化を、文化として組織に根付かせ、アーキテクチャ設計にも反映させます。設計段階からコストを意識し、Cost Managementツールなどを活用して利用状況を継続的に監視・分析します。適切なマシンタイプやストレージクラスの選択、不要リソースの自動削除ポリシー、BigQueryのコスト最適化クエリなどを実践し、費用対効果を最大化します。

8. 常に設計し続ける

アーキテクチャは静的なものではなく、ビジネスや技術の変化に合わせて進化し続けるべきものです。一度設計したら終わりではなく、運用からのフィードバック(パフォーマンス、コスト、信頼性など)、新しい要件、新しい技術動向などを踏まえ、定期的に見直し、評価し、改善していくプロセス(進化するアーキテクチャ)が重要です。

9. アーキテクチャはリーダーシップ

優れたアーキテクチャ設計は、単なる技術的な作業に留まりません。プロジェクトの技術的な方向性を示し、複雑な問題を解決し、様々なステークホルダー(ビジネス、開発、運用)との合意形成を図り、チームを成功に導くリーダーシップそのものです。技術的な選択がビジネス目標達成にどう貢献するかを明確にし、トレードオフを説明し、最適な意思決定を推進する役割を担います。

適切なデータアーキテクチャ設計の底流にある原則のまとめ

クラウド設計は技術選定に加え、セキュリティ、可用性、拡張性、コスト効率、柔軟性の多角的視点が重要です。初期からセキュリティを組み込み、障害を前提とした設計で拡張性とコスト効率を両立します。疎結合設計と信頼性の高い共通コンポーネント選択は柔軟性と保守性を高めます。可逆的な意思決定とFinOps導入で財務健全性を確保し、継続的な進化とリーダーシップが求めaられます。これらの原則が持続可能で変化に強いクラウドシステムを実現します。

まとめ

今回は、下記3点について説明しました。

- データエンジニアリングライフサイクル

- データエンジニアリングライフサイクルを支える底流の要素

- 適切なデータアーキテクチャ設計の底流にある原則

データエンジニアリングは、データの生成から活用までのプロセス全体を設計・運用する基盤技術です。データの保存・変換・提供に加え、セキュリティやガバナンス、オーケストレーション、DataOpsなどの要素も不可欠です。さらに、クラウド環境におけるアーキテクチャ設計の視点を取り入れることで、拡張性・柔軟性・信頼性を兼ね備えた持続可能なデータ活用基盤が実現されます。

これからも、Macのシステムエンジニアとして、日々、習得した知識や経験を発信していきますので、是非、ブックマーク登録してくれると嬉しいです!

それでは、次回のブログで!